近日,OSDI 2023,ISCA 2023两大顶级会议放榜,EPCC实验室共有3篇高质量论文被接收,祝贺同学们!

OSDI全称USENIX Symposium on Operating Systems Design and Implementations,是操作系统领域公认的最顶级的会议。OSDI 和 SOSP 是系统领域并驾齐驱的两个顶级会议之一,曾诞生过MapReduce,BigTable,Chubby,Spanner,DryadLINQ,KLEE,Ceph,TensorFlow等高质量作品。OSDI'23本轮共有255篇论文投稿,50篇被接收,接收率为19.6%。

ISCA全称International Symposium on Computer Architecture,是体系结构领域四大顶会之一,囊括了当年最先进的体系结构成果。ISCA本次共有372篇投稿论文,接收其中79篇,接收率为21.2%。

下面我们对实验室接收的三篇论文作简要介绍:

论文1:Optimizing Dynamic Neural Networks with Brainstorm - OSDI 2023

作者:Weihao Cui, Zhenhua Han, Lingji Ouyang, Yichuan Wang, Ningxin Zheng, Lingxiao Ma, Yuqing Yang, Fan Yang, Jilong Xue, Lili Qiu, Lidong Zhou, Quan Chen, Haisheng Tan, Minyi Guo

工作简介:

动态神经网络可以在推理过程中稀疏激活不同的子网络适应不同的输入,在准确性、计算效率和泛化性方面显著显示出优于静态神经网络的优势。然而,现有的深度学习编译器主要侧重于优化具有确定性执行的静态神经网络,而忽略了动态神经网络中激活的非均匀分布带来的优化机会。优化动态神经网络的关键是数据在推理时如何动态分派到不同路径的可追溯性。这种动态通常发生在子张量级别,因此由于表达方式粒度的不匹配,现有的以张量为中心的框架很难跟踪。

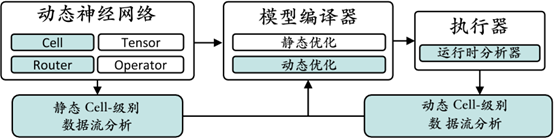

在本文中,我们提出了 Brainstorm,这是一种用于优化动态神经网络的深度学习编译器,它通过统一动态的表达方式来弥合差距,上图展示了其编译架构。 Brainstorm 提出两个关键抽象 (1) Cell,让模型开发人员表达动态存在的数据粒度,(2) Router,让模型开发人员表达 Cells 应该如何动态调度的统一接口。Brainstorm 提供高效的Cell路由执行。这种设计允许 Brainstorm 以正确的粒度收集细粒度数据流信息。可追溯性进一步为动态神经网络开辟了基于侧写的动态优化新空间,使其专门针对运行时动态分布优化代码生成。广泛的评估表明,Brainstorm 通过性能侧写的动态优化为流行的动态神经网络带来高达 11.1 倍的加速或减少 42% 的内存消耗。

论文2:OliVe: Accelerating Large Language Models via Hardware-friendly Outlier-Victim Pair Quantization - ISCA 2023

作者: Cong Guo, Jiaming Tang, Weiming Hu, Jingwen Leng, Chen Zhang, Fan Yang, Yunxin Liu, Minyi Guo, Yuhao Zhu

工作简介:

LLM(大规模语言模型,例如ChatGPT)随着模型大小的不断增加取得了巨大成功,但其模型规模的不断增长使得模型推理成本越来越高,且远远超过了硬件进步的速度。

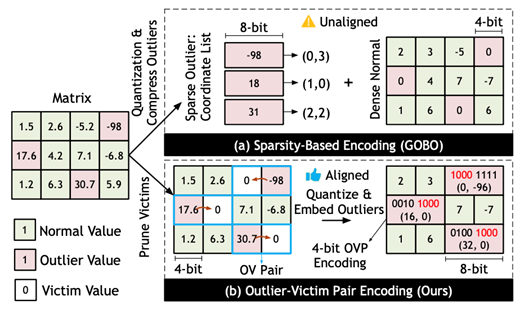

量化是加速并压缩神经网络最有效的方法之一,然而LLM中存在的outliers使得现有的量化方法不太有效。以往的outlier-aware 量化方法使用稀疏编码(如CSC、CSR等)维护异常值的位置并使用与正常值不同的量化方式,导致了复杂的编解码逻辑和额外的硬件开销,因此并不是硬件高效的。

OliVe的关键观察是基于异常值的重要性,异常值对LLM精度影响很大,因此比较重要,而与其相邻的正常值则不重要。因此这些正常值可以被剪枝(称为Victim),利用这些Victim带来的额外空间,使用高精度的方法标记异常值,从而实现内存对齐的编码方案,并直接集成到现有的硬件加速器(例如,systolic array和tensor core)中。本文基于此想法提出了一种对硬件友好的量化方法以及高效的硬件设计与实现OliVe,能够对LLM进行无需训练的快速量化,在加速LLM的推理速度,减少运算所需开销的同时,保证LLM的准确率与性能表现。基于OliVe的加速器比现有的加速器GOBO获得了3.4倍的加速比并减少了60%的功耗。

论文3: Architecting Efficient Multi-modal AIoT Systems - ISCA 2023

作者: Xiaofeng Hou, Jiacheng Liu, Xuehan Tang, Chao Li, Jia Chen, Luhong Liang, Kwang-Ting Cheng, Minyi Guo

工作简介:

近来,多模态计算由于其多元环境感知的能力以及突出的准确率优势,在边缘自主AIoT应用场景(比如无人机、自动驾驶等)中发挥着日益重要的作用。然而,多模态计算采集和感知多种模态信息消耗了大量能源,这将使其很难被真正地部署在实际的、能源受限的边缘AIoT系统中。针对这一挑战,该论文提出了自适应模态门控技术(Adaptive Modality Gating)。通过平衡情景感知能力和能效优化目标,所提出的技术能够为不同的多模态计算任务自适应地感知和计算不同模态信息,进而提升系统的感知和计算能效。

具体来说,AMG包含两个层面的技术创新:1)在架构层面,它引入了一个新颖的解耦模态传感器架构,以支持模态传感器的部分节流。这样做可以保持模态传感器数据流,同时大大地减少AIoT的能耗。2)在系统层面,AMG实施了基于新架构的智能能耗管理策略,允许AIoT系统进行初始化和自我调整,并且根据任务计算性能的情况,主动做出反应以辅助和增强门控过程。实验分析标明:相比现有技术,AMG不仅能够满足所有的多模态智能任务的精度和延迟要求,还能够在相同的能源预算下将AIoT的寿命提高了74.5%至133.7%。